008 Transformer入门到精通

Chapter 1 课程介绍

1.1 课程介绍

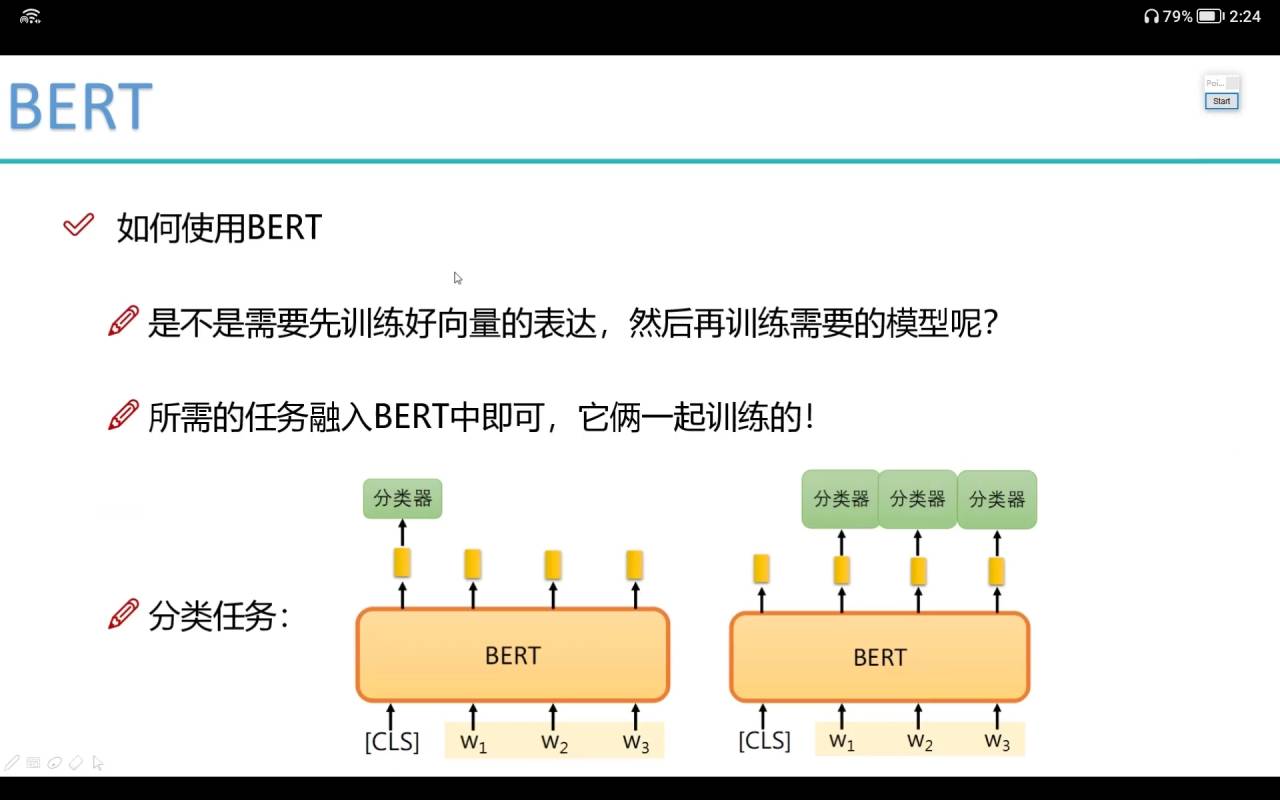

Chapter 2 BERT原理解读

2.1 BERT任务目标概述

2.2 传统解决方案遇到的问题

2.3 注意力机制的作用

2.4 self-attention计算方法

2.5 特征分配与softmax机制

2.6 Multi-head的作用

2.7 位置编码与多层堆叠

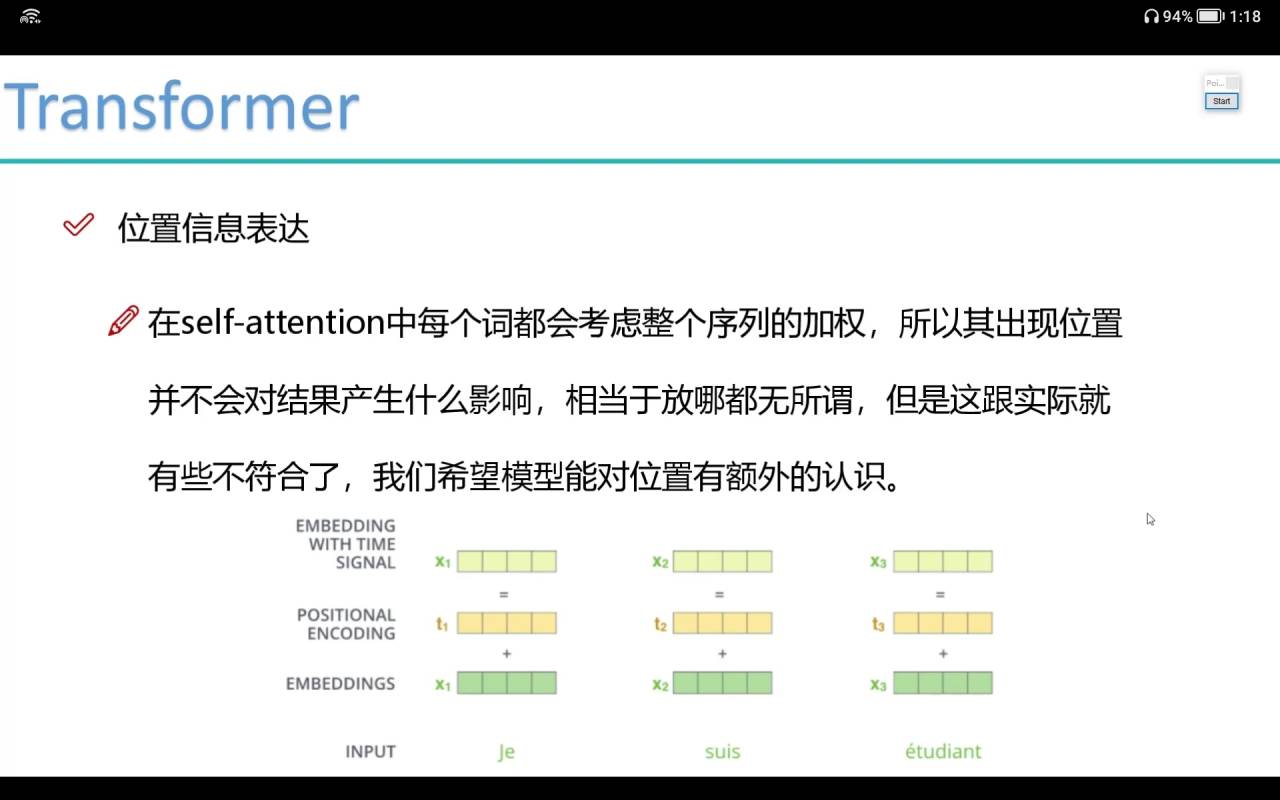

1、位置信息表达

不用one-hot进行编码,通过正弦和余弦的position位置信息

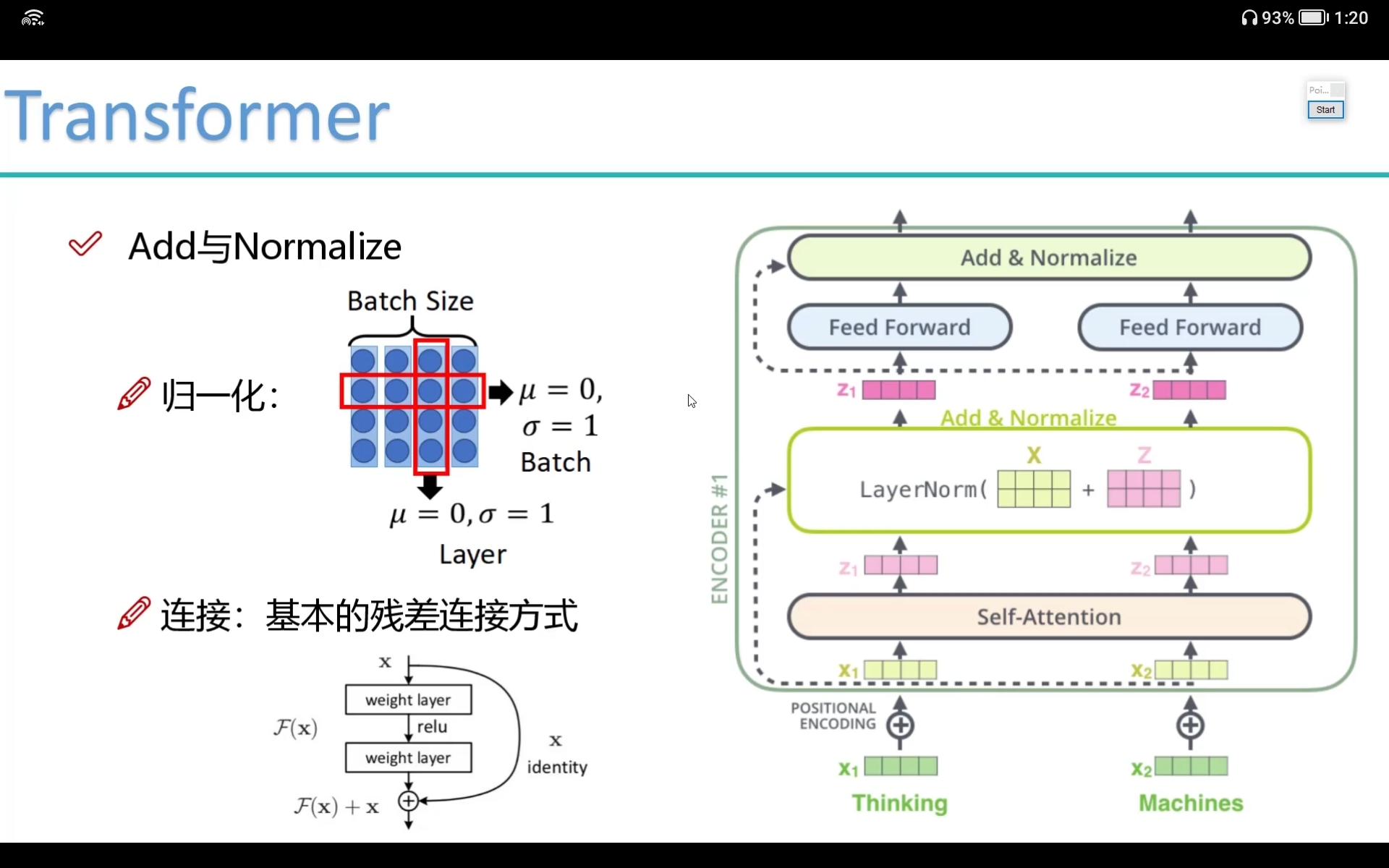

2、Add与Normalize

2.1 归一化

原始数据x = (x1,x2,x3,x4)

2.1.1 BatchNoralize

按照batch的维度(x1i,x2i,x3i,x4i)(列的维度)进行归一化,均值为0,方差为1

2.1.2 LayerNormlize

针对每个x进行归一化(xi1,xi2,xi3,xi4)

2.2 连接:基本的残差连接

原因:处理之后的x不一定比原始的x特征要好,至少不比原来差

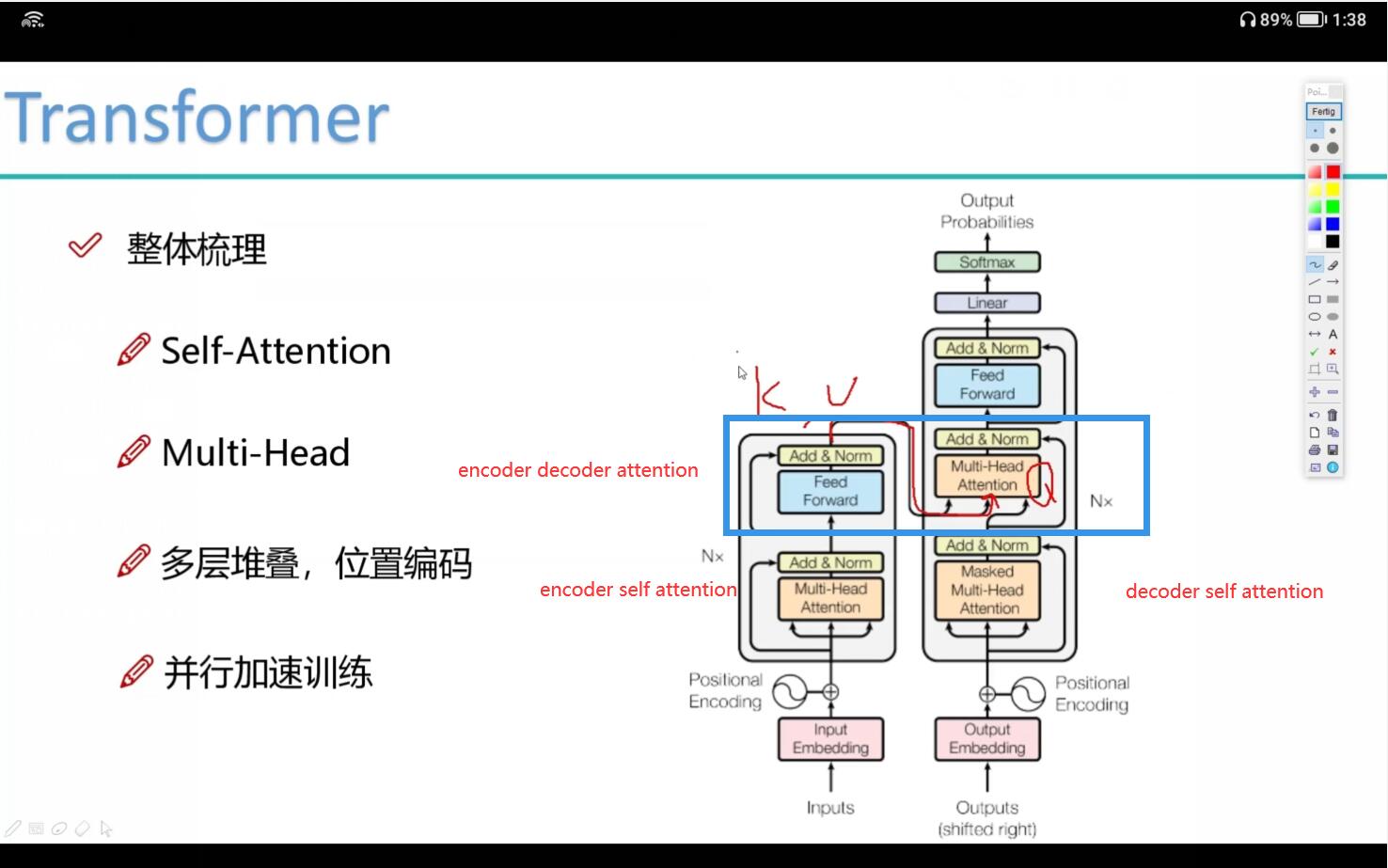

2.8.transformer整体架构梳理

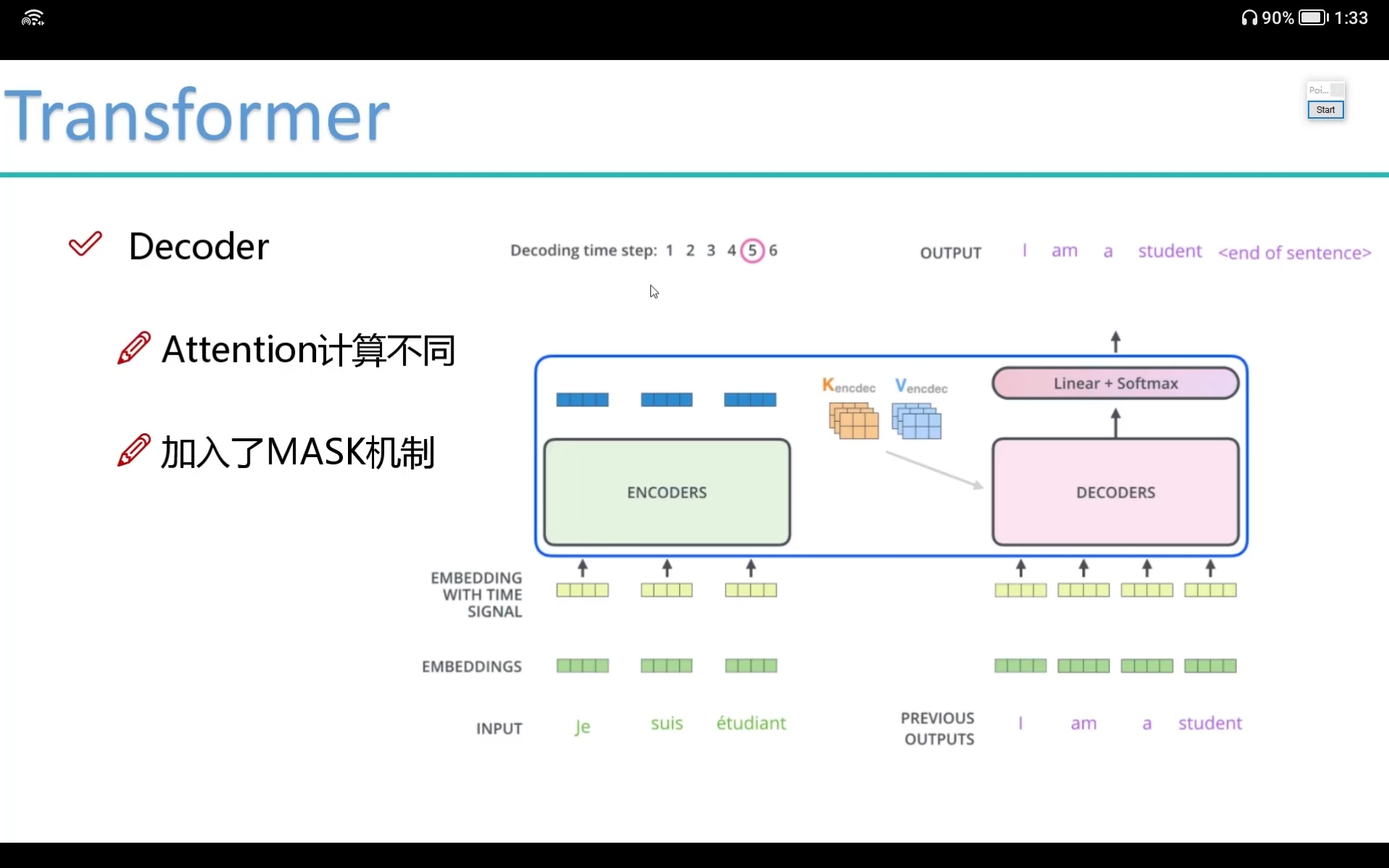

1、Decoder

1.1 Attention计算不同

- Encoder部分提供K、V,Decoder部分提供Q,进行encoder-decoder attention计算

1.2 加入MASK机制

- encoder部分是并行的,每个词同时计算self attention计算

- decoder部分是串行的,每个词y4都考虑前面的序列(y1,y2,y3),且不用y5进行attention计算,只能用他之前出现过的

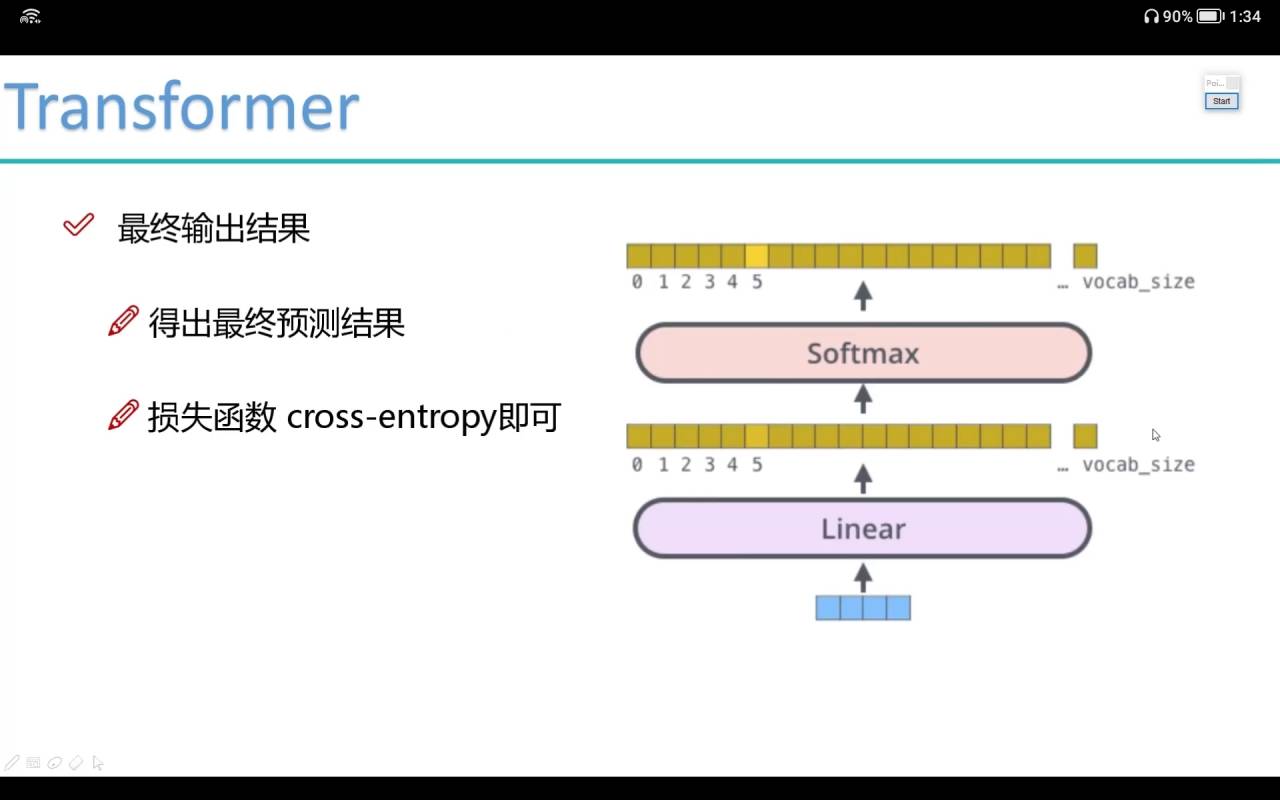

2、最终输出结果

3、整体梳理

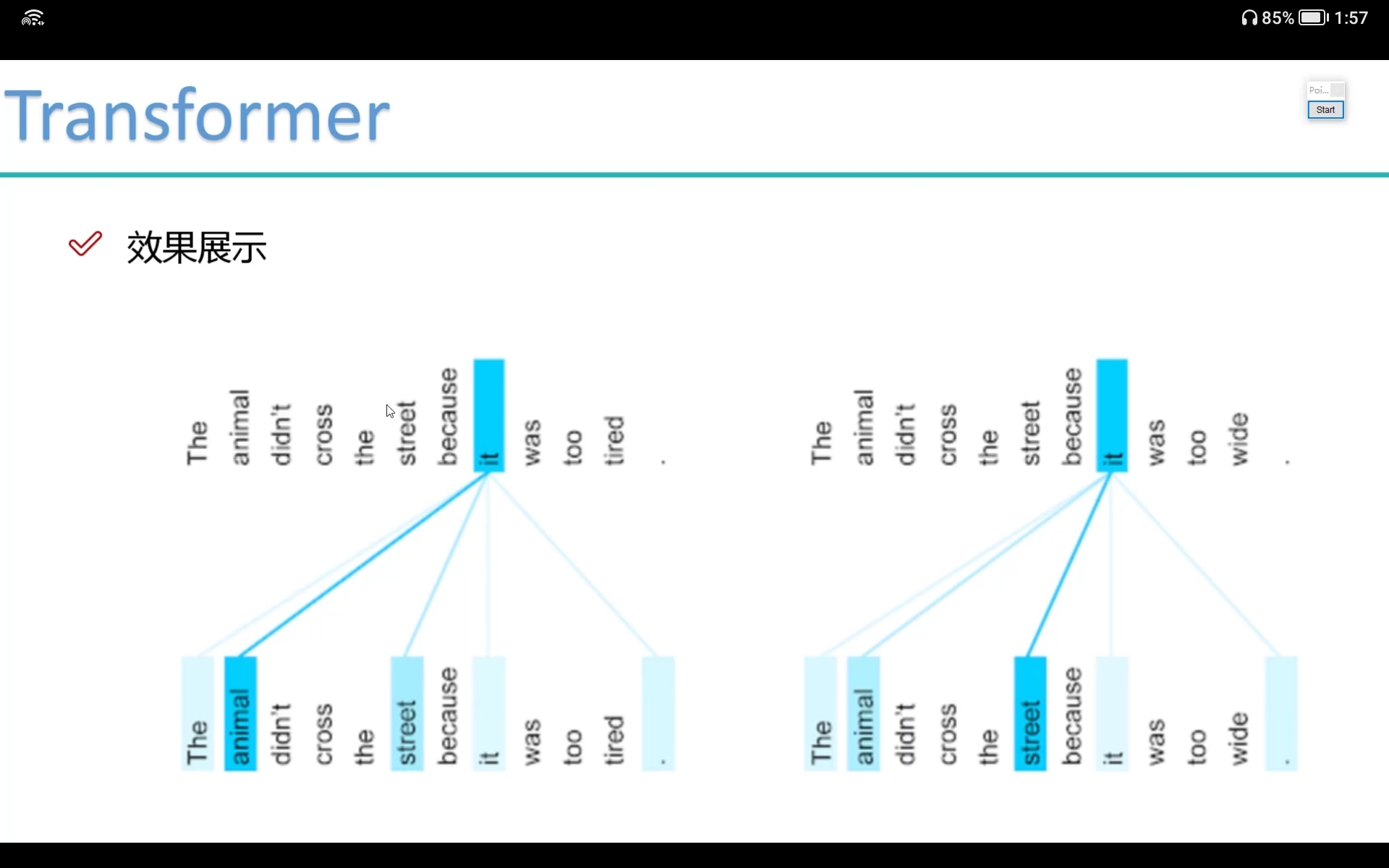

4、效果展示

2.9.BERT模型训练方法

1、BERT训练的词向量有什么不同?

- BERT = 基于Transformer的encoder端做一个向量

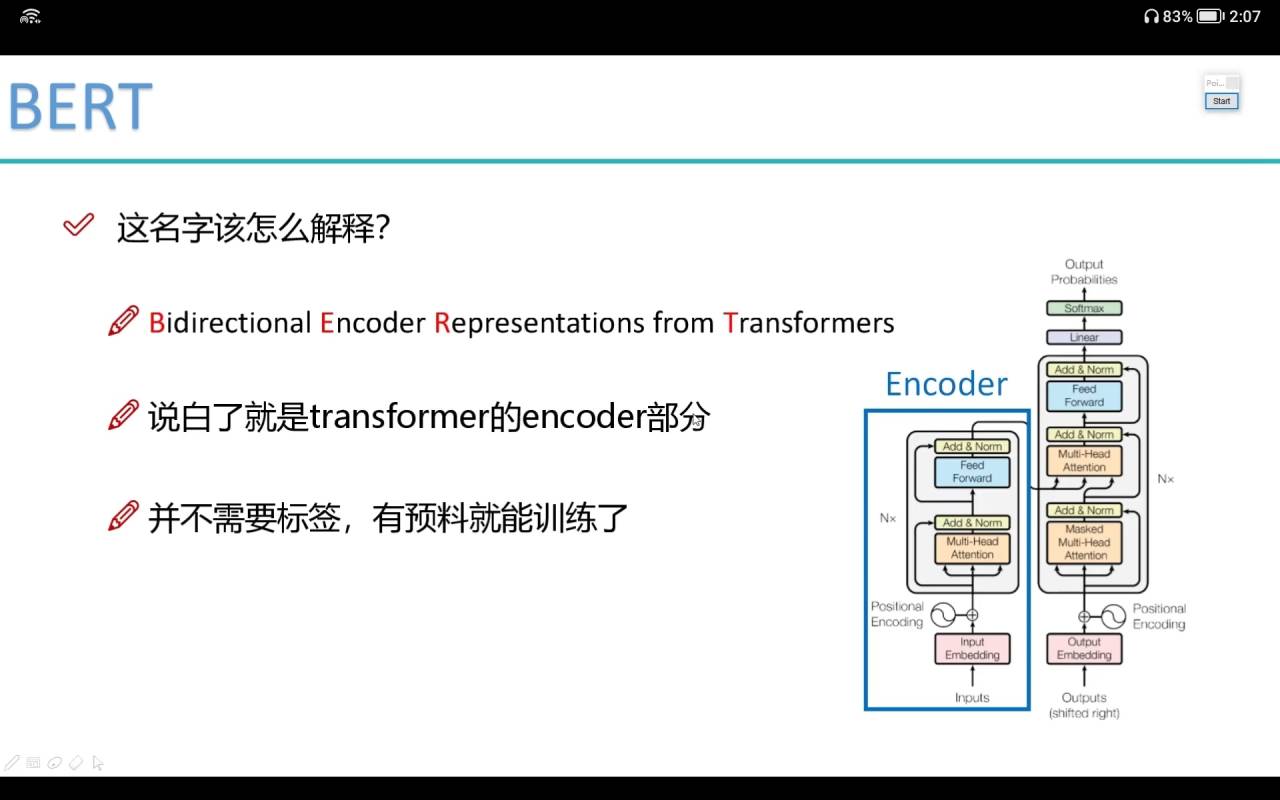

2、这个名字该怎么解释?

- word2vec也不需要标签

3、如何训练BERT?

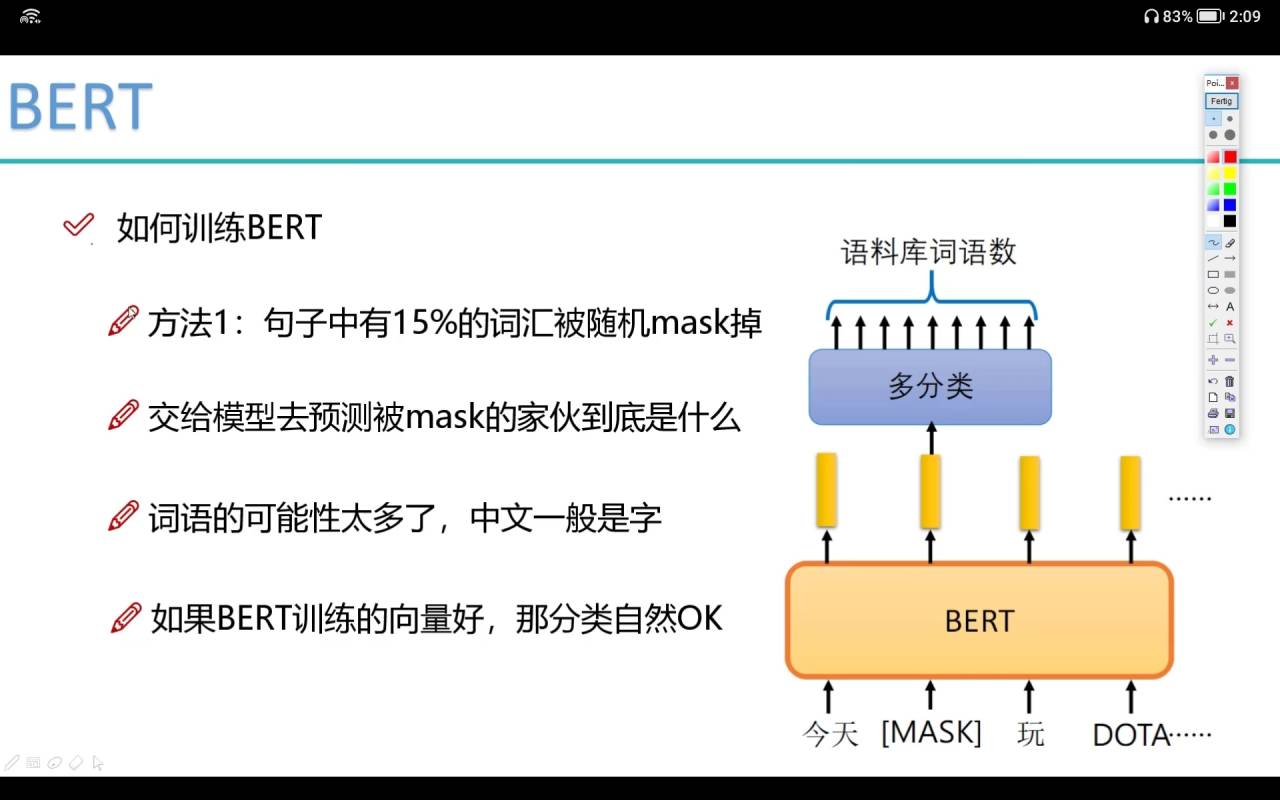

- 方法1:

- 1.句子中有15%的词汇被随机mask(mask方法 1.直接mask掉 2.替换成其他的词)

- 2.模型去预测mask的词是什么

- 3.词语太多了,中文一般用字

- 方法2:

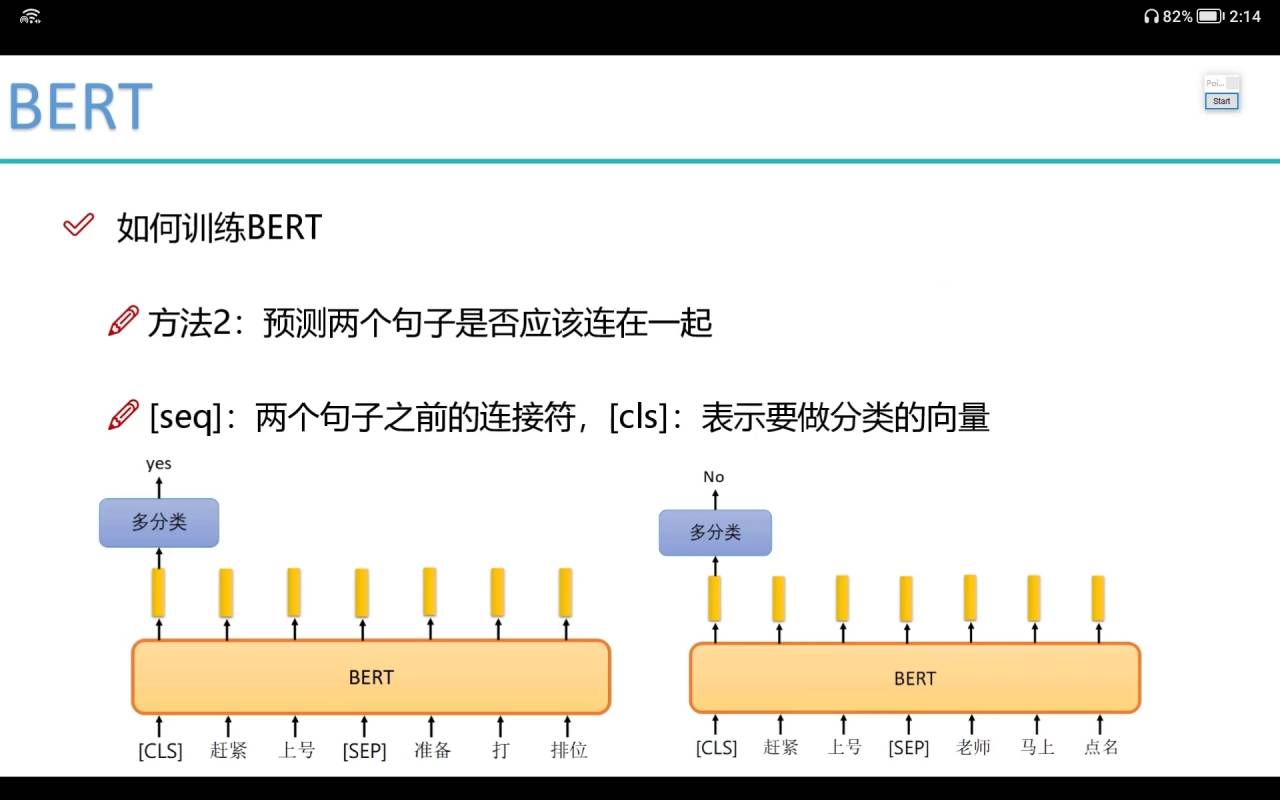

- 1.预测两个句子是否应该连在一起

- 2.[seq]:两个句子之间的连接符

- 3.[cls]:表示要做分类的向量(因为是self attention 所以最后的分类cls放在哪里都可以)

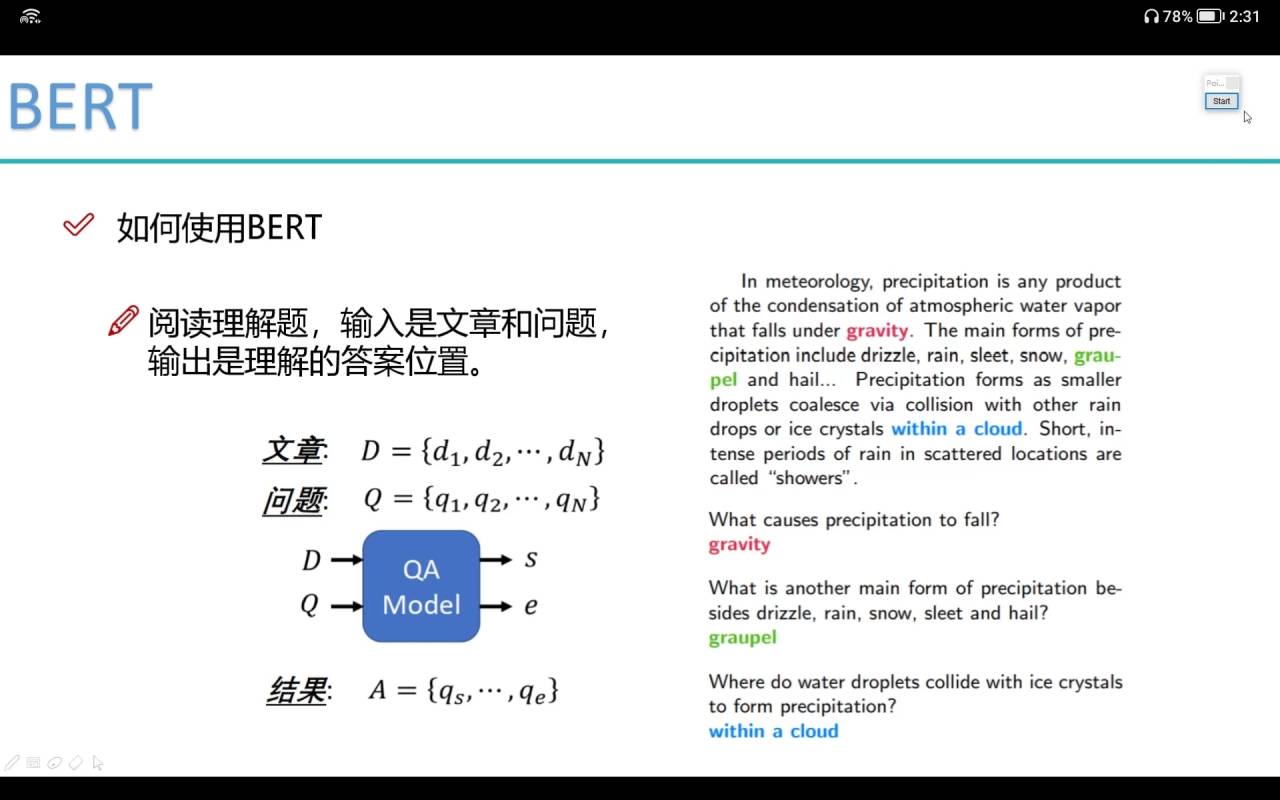

2.10.训练实例

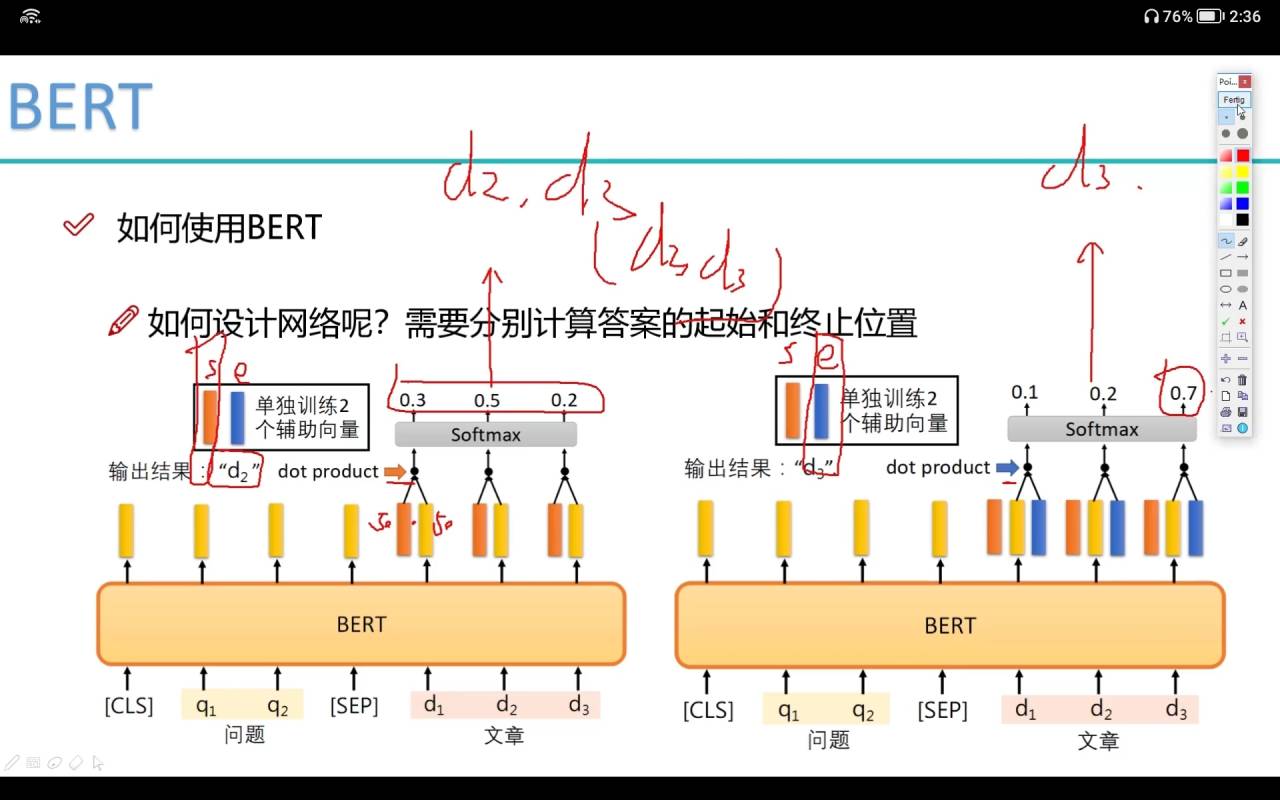

- 多引入了2个辅助训练向量s和e,其中s和e分别和

做内积,然后softmax选择概率最大的

Chapter 13 BERT源码解读与应用

13.1 BERT开源项目简介

13.2 项目参数配置

13.3 数据读取模块

13.4 数据预处理模块

13.5 tfrecord制作

13.6 Embedding层的作用

13.7 加入额外编码特征

13.8 加入位置编码特征

13.9 mask机制

13.10 构建QKV矩阵

13.11 完成Transformer模块构建

13.12 训练BERT模型

Chapter 14 基于BERT的中文情感分析实战

14.1 中文分类数据与任务概述

14.2 读取自己的数据集

14.3 训练BERT中文分类模型

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 michealxie94!

评论